MIAMI 讓你在混合實境中創作AI音樂

在先前的文章「今晚,來點 AI 做的巴薩諾瓦!」,我們介紹了使用文字生成音樂的 AI 產品、也介紹了透過對手部測距產生聲音的樂器。那如果我們將兩者結合,嘗試透過手部動作來操作 AI 生成音樂會帶來什麼樣的體驗呢?

今天要介紹的音樂介面 —— MIAMI (Mixed Reality Interface for AI-based Music Improvisation) 就實現了這個想像,MIAMI 由日本慶應大學的 Ryogo Ishino 以及 Nao Tokui 在 NIME 上所發表,是一個整合了混合實境 (MR) 、生成式 AI 以及手勢感測的系統。

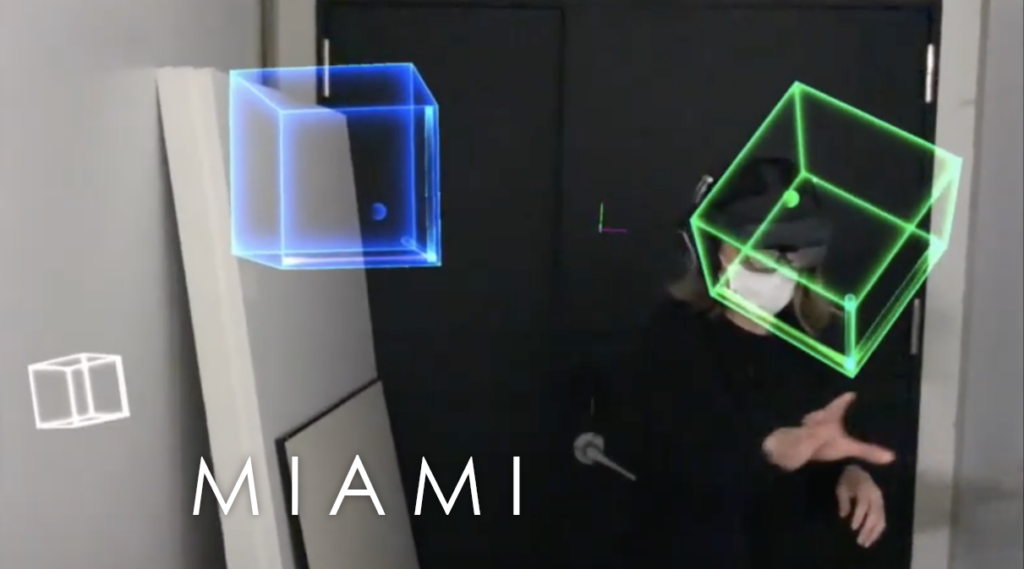

使用者可以透過 MR 眼鏡看見虛擬空間中的數個不同顏色的立方體,透過移動、旋轉和拉伸這些立方體,來生成音樂樂段,並改變音色和音量。

整體系統設計

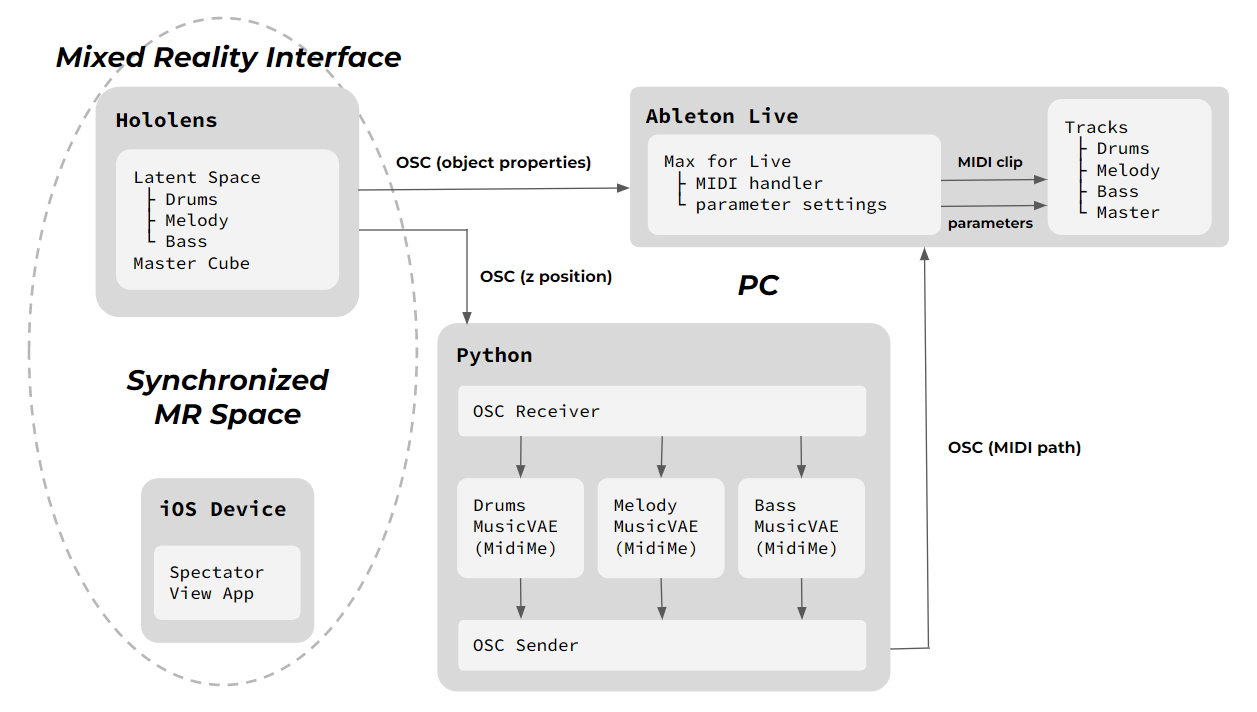

MIAMI 的實現是靠整合了多種軟硬體的產品製作成系統,我們可以把它分成三個部分來看, MR 空間的設計、 Python 伺服器運算、最後由 Ableton Live 產出音樂。

MR 空間設計

MIAMI 使用了微軟的 MR 眼鏡 Hololens 將虛擬空間視覺化,透過 MR 眼鏡的特性,讓四種顏色的立方體看起來像是懸浮在現實之中。這些立方體的製作和定位使用了常被用來製作 3D 物件的軟體 Unity ,每一種顏色的立方體代表了一種樂器,紅色代表旋律、綠色代表鼓組、藍色則代表 Bass 、白色的方塊則能進行簡易的母帶後製 (Mastering) 。

每個立方體的大小、位置和旋轉角度都被設定成代表特定的音樂性質要素,並在被手部調整過後會馬上呈現在音樂上,因此能進行 Real-time 的即興操作。在正方體的中心會有一個圓球,用來產生不同的樂段,產生的樂段會等當下樂段結束後才開始播放。

立方體空間與音樂性質的對應如下

由於 MR 空間只有配戴眼鏡的人才能看見,因此研究人員也另外串接了一台 iOS 的設備,讓旁觀者能夠過螢幕看見虛擬空間中發生的事。

Python 伺服器運算

在 MIAMI 系統中,Python 伺服器扮演了音樂生成的核心角色。它依據下述步驟接收來自 MR 眼鏡的立方體狀態資料,並將其轉換為音樂。

- 資料接收:Python 伺服器會透過一種稱為 OSC (Open Sound Control) 的通訊協定,接收來自 MR 眼鏡的立方體狀態資料。這些資料包含了立方體的 位置、旋轉角度、大小等資訊。

- 音樂生成:Python 伺服器根據接收到的立方體狀態資料,使用生成式 AI 模型來生成音樂的資料。生成式 AI 模型會根據立方體的狀態,生成對應的 音符、節奏、音色 等音樂資訊。

- 音樂輸出: Python 伺服器將生成的音樂資料傳送給 Ableton Live 軟體,由 Ableton Live 進行播放。

在模型的使用上, MIAMI 系統使用了 MidiMe 模型作為生成式 AI 模型。MidiMe 模型是一種小型化的變分自編碼器 (VAE) 模型,可以將音樂資料壓縮成低維度的潛在向量 (latent vector),並在潛在向量空間中進行音樂生成。

當使用者調整立方體的狀態時,Python 伺服器會將新的立方體狀態資料傳送給 MidiMe 模型。MidiMe 模型會根據新的立方體狀態資料,在潛在向量空間中生成新的潛在向量。最後,Python 伺服器會將新的潛在向量轉換為音樂資料,並傳送給 Ableton Live 進行播放。

Ableton Live 產出音樂

在 MIAMI 系統中,Ableton Live 負責播放生成的音樂。它同時接收來自 MR 裝置與 Python 伺服器的音樂訊號,並將其轉換為實際的聲音。Ableton Live 會根據接收到的音樂資料,使用音訊合成器來生成音訊,根據音符、節奏和音色等資訊,生成對應的聲音。

結語

目前 MIAMI 還是個探索性的系統,需要多種設備的串接才能實現,在技術和經濟的層面上嘗試的門檻仍較高,但未來若 MR 眼鏡的技術更加進步,例如具有更高的算力,或許就能只靠著一項穿戴式裝置來呈現相同甚至更好的體驗。

參考資料

MIAMI: A Mixed Reality Interface for AI-based Music Improvisation

相關文章

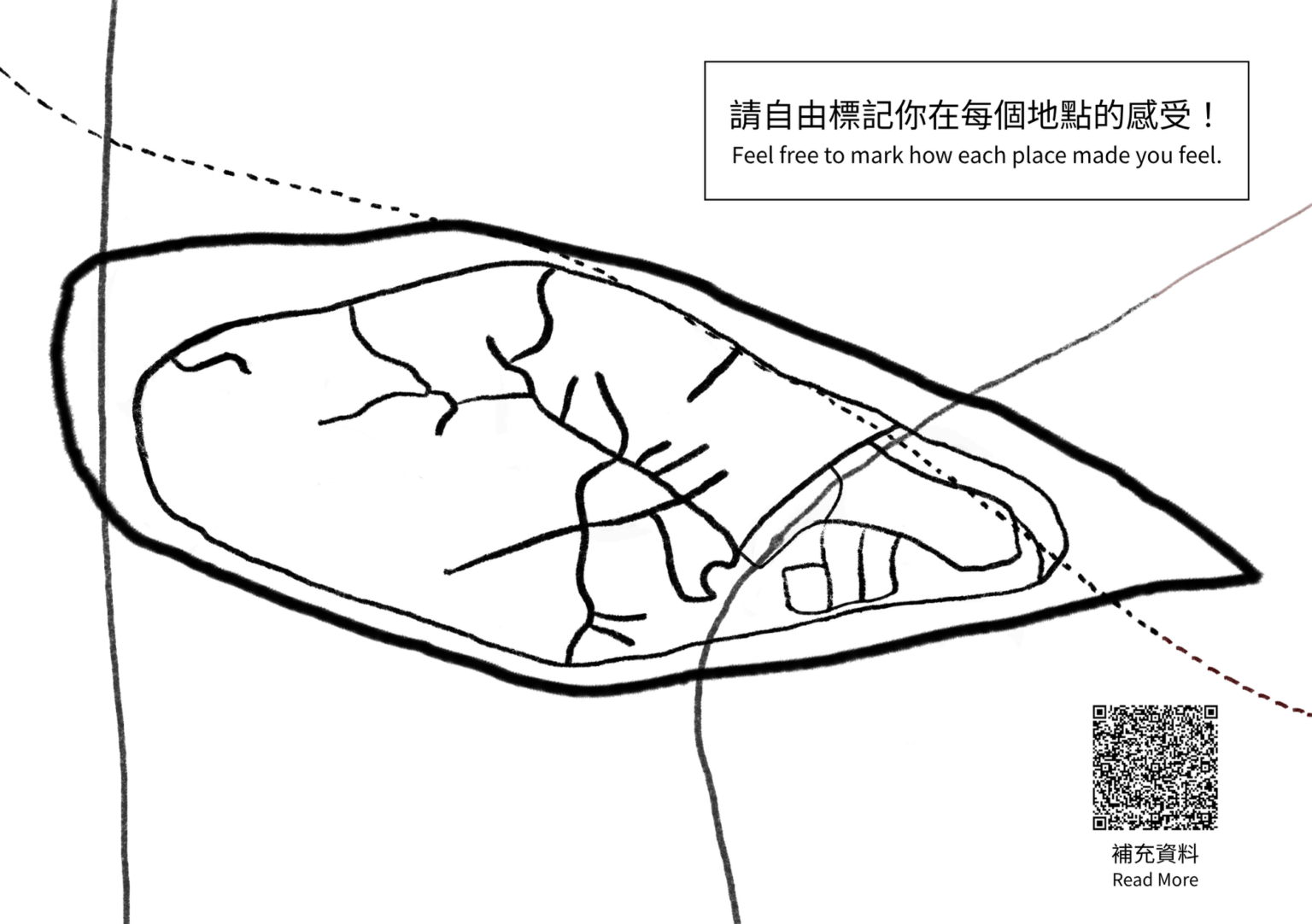

在舊港島練習節奏分析:從 Lefebvre 的 Rhythmanalysis 談起

參考法國思想家 Henri Lefebvre 在《Rhythmanalysis》提出的節奏分析,我們把夜間與日間的走訪、感知卡片、島嶼模型製作等活動,視為一次在現場展開的節奏實驗。這篇文章整理這套方法背後的理論線索,也說明它如何被轉寫成實際可操作的感知工具。