【作品介紹】《Still, Life》音樂行為藝術——人、音樂、科技之對話

在網路時代下,資訊唾手可得,任何人都可以透過網路來取得想要的資訊,許多「專業知識」透過網路就可以學習,現代創作門檻相對變低:人人都可以成為剪接師、平面設計師、音樂製作人⋯⋯;甚至利用素材拼貼,不需要工藝技巧或基礎,即能成為藝術家——早在杜象(Marcel Duchamp)在小便斗上簽名,就宣告著重手藝的時代已過去;將素材概念延伸,衍生出現代網路上流行的梗圖生成器、論文報告生成器、變臉應用程式⋯⋯等,有工具便能交出屬於自己的作品。

接著AI(artifical intelligence)人工智慧出現,對全世界的生產者都產了極大的衝擊。人工智慧幾乎等同於大腦,可以訓練它學習,因此它也能創造;機器藉由生成對抗網路(generative adversarial networks)模仿學習,即能創造出一個全新的,以前並不存在的事物——一系列的「This X Does Not Exit」誕生。這時不是單純的素材拼貼,而是創造出全新獨一無二的原創作品。

▲2018年,世界首次拍賣由AI創作的作品《Portrait of Edmond Belamy》,在佳士得拍賣會上賣了43.25萬美元

藝術家楊謹庭(以下簡稱她)在大學讀戲劇系時,「音樂設計」在她的學校是相對比較不被重視的一部份——比起燈光設計、舞台設計,音樂設計給人一種「誰都可以找現成音樂來配」的感覺。事實上,甚至連她在設計配樂時,出現了把同一首歌曲用在不同案子,兩邊都能用的情況。在創作配樂時,她不禁思考,量身定制的原創音樂目的為何?現今許多廣告、影片之配樂,都使用版權音樂,快速且便宜。或許,有一天AI能取代人類,創造出同樣原創,也能帶動情緒的音樂?在創作過程中,她不斷思考,「原創配樂」的必要性為何?電影配樂若少了影像,他們是可以獨立存在的偉大創作嗎?人類原創之「純音樂」主體性為何?科技哪一天會全面取代人類創作?回想最初創作音樂的原因——就只是單純地藉由藝術傳遞分享她自己的情感,而若是能得到一個回饋,一位知音,便心滿意足。

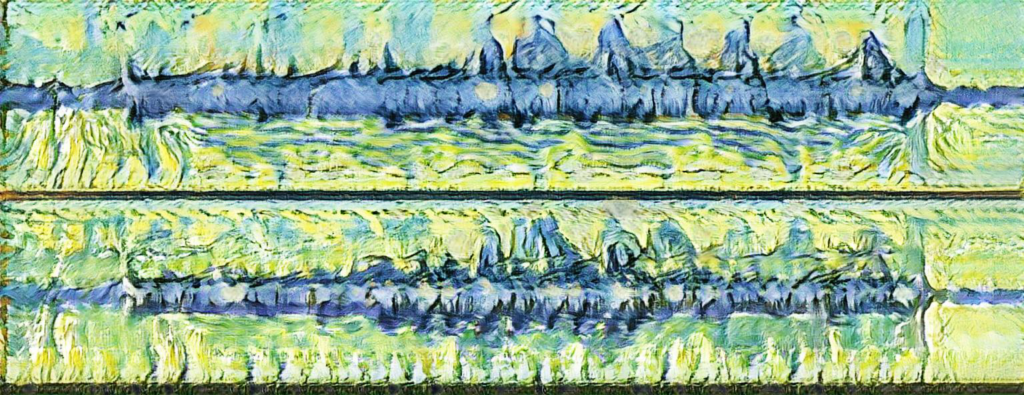

▲使用Runway生成之影像

聲音表達為人類與生俱來的天賦,也是我們最早用來表達情緒的方式——從嬰兒時期的哭鬧、牙牙學語,接著有語言,最後才漸漸發展成文字;若是沒有文字,我們依然可以溝通。在她大學時期,表演課上會玩一種即興遊戲叫”Gibberish”:表演者必須用非真正存在的單詞語言,以類似純聲音、自創語言的方式來說台詞;若是你能藉由一串胡言亂語成功讓對手演員和觀眾理解你想說的話,說正式台詞時,你才有可能真誠地表達出角色的心聲。透過音樂來和人交流,因此「面對面」之形式也成為重要元素。

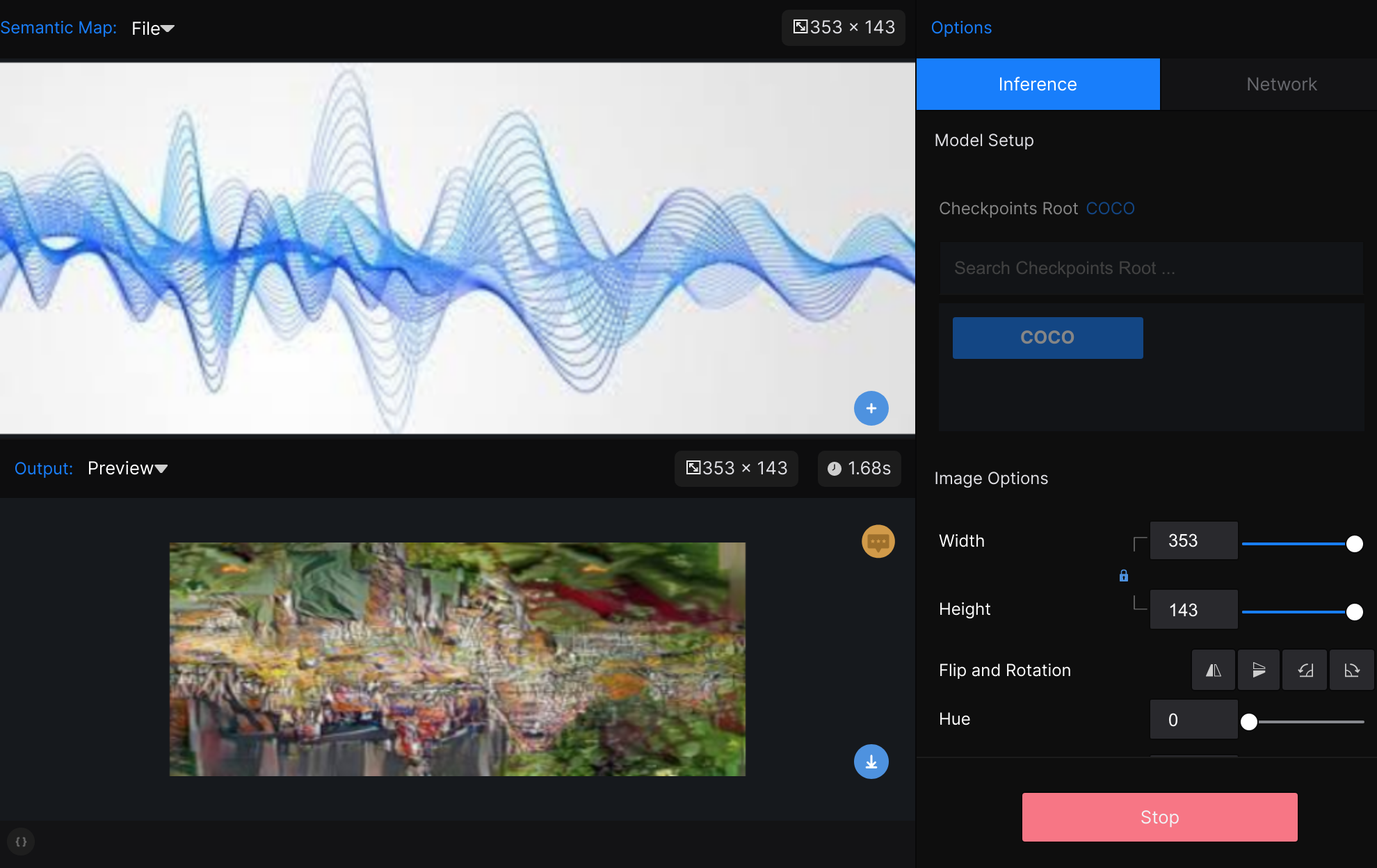

▲ 使用Runway ML,資料輸入來源為音訊波形圖檔(上方),程式依據此圖檔以及資料庫,自動輸出生成下方的新圖檔。

在此計畫中,藝術家與觀眾面對面之過程,接受觀眾之表情與其在演奏過程中之任何情緒交流,進而影響音樂創作。藝術家與其觀眾需產生對話,作品才完整地成立,整個面對面演奏過程,構成此作品重要部分。楊謹庭希望藉由此作品,能找回創作最初的單純,同時也和科技產生對話,探討觀眾、藝術家、科技三者之間密不可分的連結。

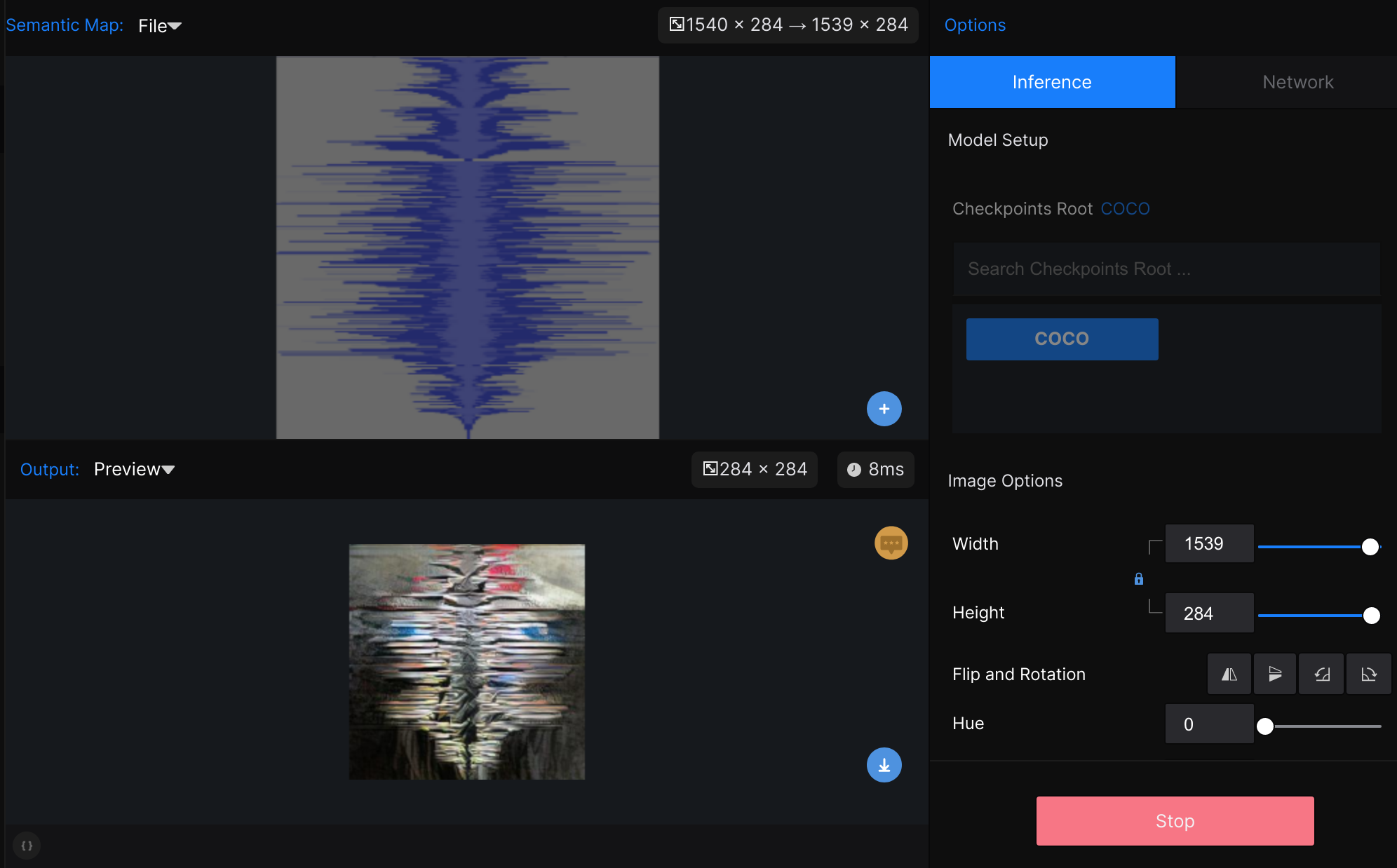

▲ 使用Runway ML,資料庫可自定義,因此可訓練出具有個人風格的AI圖片生成模型。

此計畫使用Runway ML:使用者不需會程式語言,透過Runway即可使用機器學習,創建自己的AI合成圖像模型(model)。Runway使用StyleGAN訓練自定義圖像生成器,使用者可以創建具有獨特風格的圖片生成器,操作介面輕易上手,也能方便地訓練機器學習生成之風格。此程式也可接收與傳送其他程式傳輸協定並與多種程式結合使用,例如:Max/MSP、p5.js、AbletonLive。最終希望能做到即時生成影像的聲音視覺化過程,對應出以音符作為畫筆的感受。