AI驅動的Beatbox創新:Max與Wekinator實現人聲節奏表演

想像一下,在一個充滿活力的街頭藝術表演中,觀眾圍繞著一位Beatbox高手,他僅用嘴巴就能製造出令人驚嘆的音樂。這種用人聲模仿鼓樂的藝術,通常讓旁觀者深感羨慕。但現在,這種技藝不再是少數人的專利。透過創意編程、基礎的人工智能(AI)知識,以及一些現成的開源工具,每個人都能踏上這樣的音樂創作之旅。

機器如何分辨聲音的差異

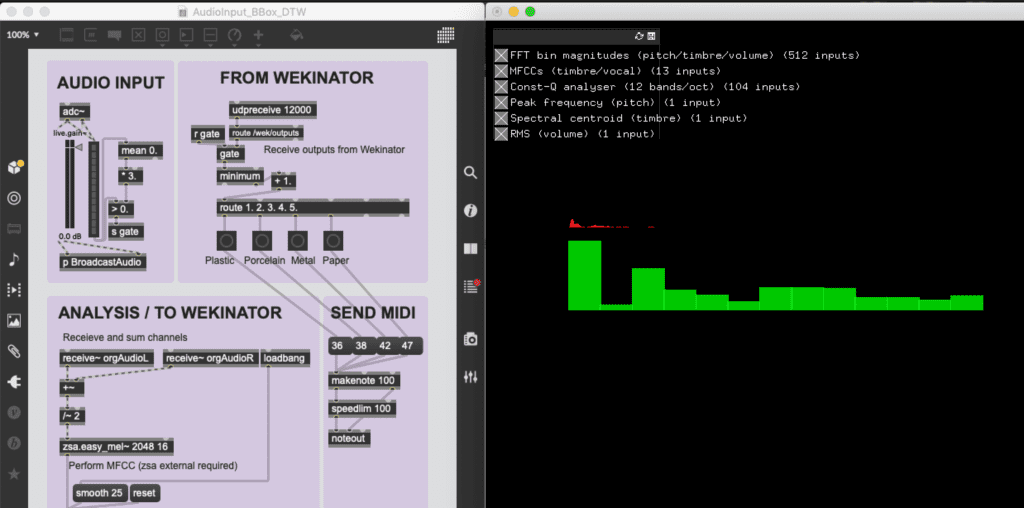

讓我們深入探索這個過程:如果能用自己的聲音來控制音樂節奏,那會是怎樣的一種體驗?當你輕輕發出「咚」這一低沉的聲音,電子大鼓的聲音隨之響起;而當你更加活潑地發出「大」聲時,小鼓的節奏便跟隨其後。首先,我們要去分析不同鼓單元在音色(泛音組合)、音量變化(如Amplitude的Envelope)上的差異。雖然我們可能有辦法用耳朵仔細聆聽並描述其差異,但聲音畢竟倏忽即逝,要抓到頻率跟時間軸上的所有差異,透過電腦輔助紀錄及分析,還是會讓整個實驗過程更有效率。而這一切,都可以通過Max的內建功能或是第三方開發的Max物件,串連簡易機器學習模型(現在大家通常稱其為AI)實現。這些新興工具通常能抓取不同的聲音特徵(如音量或音高,本篇範例是混用RMS及MFCC來做音訊輸入分析),能夠精準地捕捉你的聲音,並將其轉化為豐富的音樂元素。

我們提供了一系列延伸閱讀資源引導你探索音樂領域的創意編程(creative coding)及音樂信息檢索(Music Information Retrieval, MIR),讓你了解如何利用這些工具來激發創造力。無論你是一名音樂愛好者,還是尋求新創意的藝術家,這些工具都將為音樂創作之路帶來新的靈感和可能。

延伸閱讀:今天就來初步認識 Max/MSP!-音訊篇

延伸閱讀:給麻瓜的機器學習軟體Wekinator介紹

用人聲觸發不同的鼓聲樣本

為了更直觀地展示這一技術的應用,我們準備了一段簡單的示範影片。在這個示範中,您將看到我們如何利用Wekinator與Max的強大組合來創造音樂。這個過程涉及到使用「分類法(Classification)」來分析和判斷我們用嘴巴發出的不同聲音,並將這些聲音轉化為MIDI信號,進而控制Ableton Live中的電子鼓樣本。

在這一過程中,我們特別選擇了具有標誌性的808電子鼓樣本作為目標聲音。808電子鼓,以其獨特的低音和強烈的節奏感著稱,是現代音樂中不可或缺的元素,特別是在Hip-Hop和電子音樂領域。這種選擇是出於對Beatbox的敬意——Beatbox通常模仿鼓聲來創造節奏,而808電子鼓則是這種藝術形式的電子對應。在我們的示範中,使用人聲來觸發這樣具有個性和象徵意義的鼓樣本,不僅是對傳統Beatbox技巧的一種現代詮釋,也象徵著人與機器之間的緊密連接。

為實現這一目標,我們利用了均方根(RMS, Root Mean Square)和梅爾頻率倒頻譜係數(MFCC, Mel-Frequency Cepstral Coefficients)這兩種演算法來分析人聲。這些技術幫助我們精準捕捉和分類聲音特徵,從而能夠準確地觸發對應的808電子鼓樣本。在這過程中,雖然動態時間彎曲(Dynamic Time Warping, DTW)的概念被納入,但由於我們的人聲模仿時長並不長,因此大幅度的時間調整並非必要。

「用聲音來觸發聲音」

這一概念不僅局限於人聲的分析與應用。以下將分享另一個涉及將日常物品轉化為音樂創作工具的測試影片。此概念萌芽自於我們去年夏天的實驗,其中使用了自行編寫的Max Patch程式,結合Wekinator來處理不同聲音特徵參數的變化。

在這段影片中,觀眾可以看到我如何將塑膠、紙杯、玻璃、金屬等常見物品變成音樂創作的觸發器。這些物品的聲音不僅是物理原聲的來源,同時也成為觸發更豐富聲音的媒介。這種方法拓展了我們對既有聲響規範的想像,使得這些平凡物件得以在音樂創作中發揮新的角色。

在影片中可以看到,日常物件如塑膠、紙杯、玻璃和金屬罐被轉化為音樂儀器,經由Zoom的H6錄音座收音,經由軟體演算後,觸發預設Drum Pack中不同的鼓組聲音樣本。這不僅使這些物件成為音樂表達的媒介,還拓展了我們對於物質和聲音共鳴的想像。

儘管這種應用在表面上看似簡單,但實際上它提供了音樂創作和聲音設計的全新視角。透過深入的訓練和參數調整,這種技術完全可以被應用在現場演出、展覽和商業案件中。在這一過程中,我們不僅學習了聲音的基本特徵,如音高和音量,還探索了如何透過音MIR和機器學習來捕捉和分析更複雜的聲音數據。這些知識和經驗將為音樂創作的各個方面,包括編曲、混音和聲音設計帶來額外效益。

創作者也能掌握的機器學習

透過結合Max/MSP與機器學習工具如Wekinator等,經由電腦及數位工具輔助,音樂創作和演出的方式得到了顯著擴展。此類工具使音樂表達和控制能跳脫過去單調的一對一映射(one-to-one mapping)方式,實現更複雜、更有創意的互動。例如,在本篇文章案例中,我們展示了如何快速簡易地利用人聲觸發不同的鼓聲,這體現了機器學習在音樂創作中的應用潛力。重點在於這些工具的整合應用,而非單一工具本身。

Wekinator作為一款開源工具,雖然只是眾多類似選擇中的一個,但它卻提供了一個低門檻的平台,讓創作者可以實驗和探索機器學習在音樂創作和演出中的應用。這不僅讓音樂家能夠更直觀地掌握並應用機器學習的技術,也展現技術與創意結合的可能性,以及它們如何共同推動音樂創作與表演藝術的進化。

相關文章

從科學家視角看待藝術與科學的跨域合作:以《真菌宇宙學 Fungi Cosmology》為例

跨域合作反映了人們對世界日益複雜的理解需求,不僅拓展了知識的界限,也帶來全新視野和思維。觀察當前的跨領域合作案例,藝術家