【創意科技】透過簡單的機器學習,來實現用「語音識別」玩小遊戲!

大家可能有在手機上玩過一些小遊戲APP,會讓玩家透過人聲來控制角色的移動。如果想要在個人電腦上達成這樣的應用,又不想要寫太多Code,我們應該怎麼透過數位工具與Creative Coding來實現呢?

下面這個影片是一個簡易示範:

https://www.youtube.com/watch?v=1S1L1ZIRebk

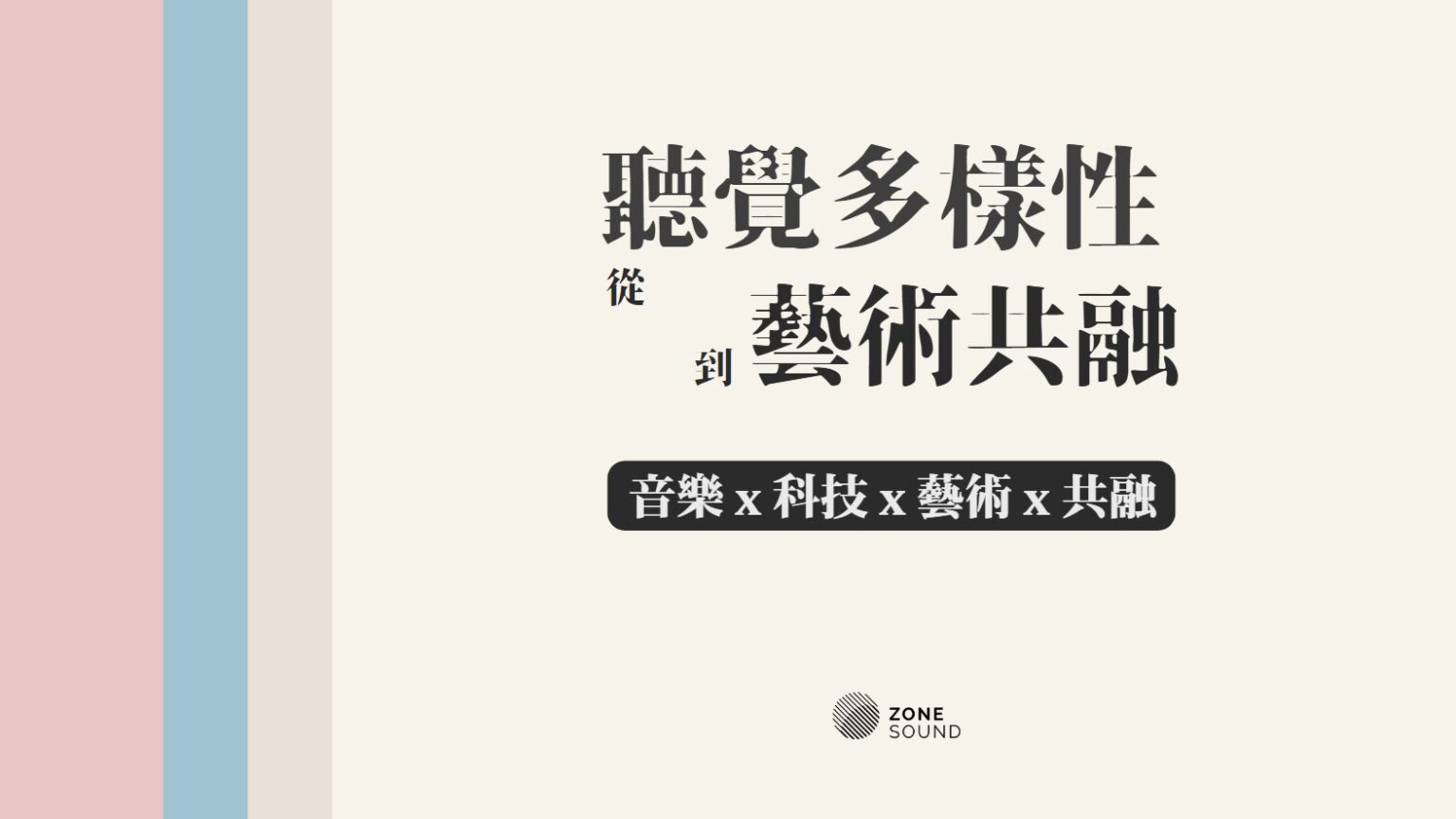

我們使用的軟體包括Processing、Wekinator跟以Openframework編寫的音訊分析軟體。在抓取出聲音參數後,就交由Wekinator來負責建立機器學習模型並分析即時數據。這邊使用的是Dynamic Time Warping,因為Voice Command都是帶有時間性的一小段聲音指令,每次可能想要下達同個指令,但聲音時間長度會不一樣,因此會需要分析Time-Based的各種Feature變化。

在影片中,大家應該都能看出,紅色小點是由聲音來驅動,我們可以透過簡單的訓練過程,讓紅點點學會往左、往右、向上跳,並透過不下任何指令的訓練,告訴系統如果沒有下達聲音指令,紅色小點就要維持停在原地不動。

有沒有覺得應用機器學習後,很多困難的事情都變得很簡單呢?大家有什麼應用機器學習的創意點子都歡迎跟我們分享、交流!

探索更多音樂、科技、藝術的交匯與創新應用,現在就訂閱我們!

相關文章

從科學家視角看待藝術與科學的跨域合作:以《真菌宇宙學 Fungi Cosmology》為例

跨域合作反映了人們對世界日益複雜的理解需求,不僅拓展了知識的界限,也帶來全新視野和思維。觀察當前的跨領域合作案例,藝術家